2022/12/6 10:21:00

あれ離散コサイン変換で手書きの特徴量抽出Cognicull文章の離散コサイン変換NNの重みを離散コサイン変換で圧縮した状態で学習する『[2112.15545] Training and Generating Neural Networks in Compressed Weight Space』『[1212.6521] A Frequency-Domain Encoding for Neuroevolution』あれ『[2309.12201] Electroencephalogram Sensor Data Compression Using An Asymmetrical Sparse Autoencoder With A Discrete Cosine Transform Layer』『!!Con 2016 - Lossy text compression, for some reason?! By Allison Parrish - YouTube』ChatGPTによるDCT-IIの微分文章を離散コサイン変換で非可逆圧縮する

文章を離散コサイン変換で非可逆圧縮する

2025/3/17 14:05:00

ChatGPTによるDCT-IIの微分

2025/3/10 5:02:00

DCT-IIの定義は

\[

X(k) = \sum_{n=0}^{N-1} x[n] \cos\!\left(\frac{\pi}{N}\Bigl(n+\frac{1}{2}\Bigr)k\right)

\]

となっています。ここで、\( x[n] \) は入力系列です。この式は線形和であり、各 \( x[n] \) は独立した変数です。そのため、ある特定の \( m \) に対して偏微分を考えると、

\[

\frac{\partial X(k)}{\partial x[m]} = \cos\!\left(\frac{\pi}{N}\Bigl(m+\frac{1}{2}\Bigr)k\right)

\]

となります。すなわち、\( x[m] \) に関する偏微分は、その項の係数である余弦関数そのものとなります。

『[1212.6521] A Frequency-Domain Encoding for Neuroevolution』

2024/8/4 23:23:00

あれ

2022/12/8 22:12:00

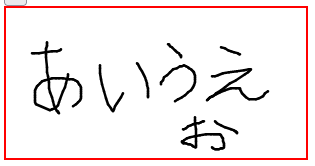

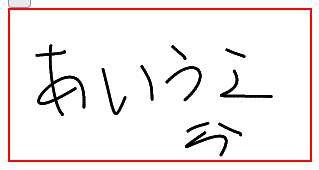

手書き検索の処理をローカルPCで試してるんだけど、1つ書くごとにPCがうなりを投げてる。その割に検索精度が低い。

検索に使う特徴量を事前計算して、さらに索引にすれば処理の負荷が減らせそうなんだけど、現時点では検索精度向上に向けた開発を高速化するために毎回特徴量を計算してる。

手書きの図の類似度判定は、離散コサイン変換してその係数のユークリッド距離を取ってる。いろいろ試したけどこれが一番精度が良い(なお精度が低い)。オートエンコーダーが脳裏をよぎる。ニューラルネットワークやりたくねぇずら。

検索精度向上のために、手書きの軌跡を結合してたらサーバープログラムが落ちた😇