あれ

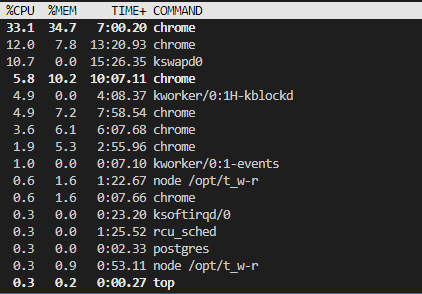

User-Agentを一般のコンピュータに偽装してクロールする輩が来て気になったのだが、私が動かしてるデライトをクロールするクローラ(dlt_crawler.js)のUser-Agentは何になってるんだろう。Node.jsでgotを使っているので、gotになっているはず……?

Node.jsでgotを使った際のUser-Agentはgot (https://github.com/sindresorhus/got)となっていた。実際にサーバにgotを通してアクセスし、アクセスログを確認した

gotのレポジトリでuser-agentと検索してみると、headersという引数でUser-Agentを設定できそうだ。

headers: {

'user-agent': undefined

}

とりあえず、dlt_crawler.js by t_w(https://towasys.com/)としておこう。こちらUser-Agentが反映されていることをサーバにアクセスして確認済みだ。

コードは以下のようになった。

response = await got(url, {

headers: {

'user-agent': 'dlt_crawler.js by t_w(https://towasys.com/)'

}

});

というかrobot.txtをガン無視しているのでお行儀が悪い気がしてきた。さらっと調べたらデライトにrobot.txtは設定されていないっぽい……?じゃあいいか……いいのか?

dlt_crawler.js

MJ12bot

DotBot

あれ

アメリカと戦うと言った意味では、まともな国産検索エンジンがないのが口惜しい。陰謀論みたいになってしまうが、アメリカがその気になればGoogle検索にくだらない記事を混入させるといったこともできてしまう。意図的じゃなくとも、検索結果にかける熱量もとい手間の量がそもそも違うだろう。ただ、現時点の話をすれば、Google検索は日本語を重要視しているらしい。

そう言った意味では、ローカルのPCでクローラを回してオープンソースの検索エンジンを動かすというのは悪いアイデアじゃない。今流行りのプライバシーにも完璧に対応できる。ただ、インターネットの圧倒的な物量にはインデックスであってもローカルのPCには入りきらないということが絶望的に欠点だった。

今から追い上げるのは難しいにしても、いつでも作れるような地固めはできないものだろうか。

『t_wの輪郭』の輪郭に編集日時を表示

あれ

クローラー

あれ

多数の人がローカルでクローラを回すと、DDoSみたいにならないかが不安。

動画よりは帯域を食わないとは思うが、念のために計算しておいたほうが良さそう?

Web Prowlerのクローラ機能の取り外し案

重たさの原因になっている。推薦の算出対象をお気に入りと履歴だけにすれば、極めて軽量にできるはずだ。10年ほどして、一般的なPCの性能が上がったらまたクローラ機能を入れればいいだろう。

- 利点

- 実現性が高い

- 欠点

- 作るのが面白くない

- あまり便利でない